|

|

论文标题:

Fortify the Shortest Stave in Attention: Enhancing Context Awareness of Large Language Models for Effective Tool Use

巩固注意力的短板:通过增强上下文感知提高大型语言模型在工具使用方面的表现

论文作者:

陈雨涵,吕昂,林廷恩,陈畅与,武玉川,黄非,李永斌,严睿

作者单位:

中国人民大学,阿里巴巴

论文链接:

https://arxiv.org/pdf/2312.04455.pdf

三分钟读论文

Powered by AI © PaperWeekly

来自中国人民大学和阿里巴巴的研究者关注到模型的注意力分配随上下文位置的变化呈现一种“波形”,而模型的上下文感知能力与这种“波形”紧密相关。具体来说,当一段关键信息恰好位于注意力分配的波形低谷时,这部分的重要信息很容易被模型忽略从而影响输出质量。

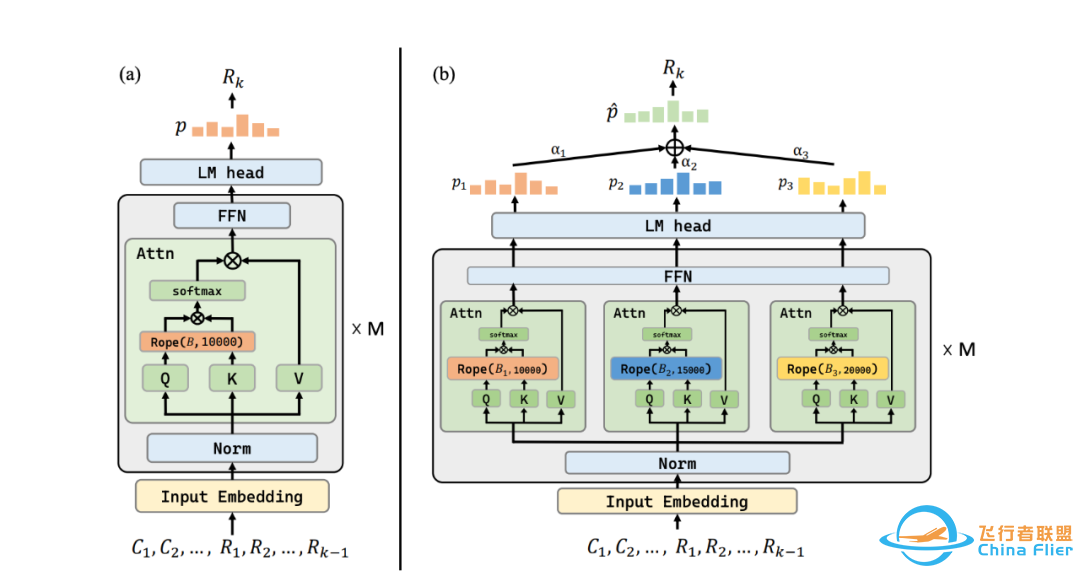

为解决这一问题,作者们提出了一种创新的模型推理方法,命名为“注意力桶(Attention Buckets)”。该方法通过并行执行多个推理过程,并对每个过程中的 Attention 模块赋予一个独特的 RoPE(旋转位置编码)底数,确保上文中一旦某一个位置恰好处于注意力的低谷,在另一并行推理过程中,该位置的信息会被调整到注意力高峰进行补偿,最终输出通过加权多个推理过程的输出得到。

该方法大幅度降低了 LLMs 忽略上文关键信息的风险。在公认的工具使用基准测试中,作者的大量实验证实了这种方法的有效性。采用了“注意力桶”技术的 7B 参数开源模型,在性能上达到了与 GPT-4 相当的水平。

旋转位置编码(RoPE)与语言模型上下文利用

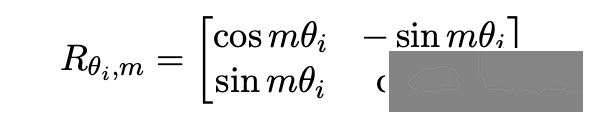

旋转位置嵌入(RoPE)[1] 是一种在大型语言模型中进行位置编码的流行技术,这些模型通常基于 Transformer 架构。在注意力计算过程中,给定序列中位置的查询或键向量,RoPE 通过一个 d 维旋转矩阵(表示为 )将位置信息编码进向量中。这个矩阵 被构造为一个块对角矩阵,包含尺寸为 的块,总共有 这样的块。具体来说,第 个块被定义为:

其中,, 被定义为旋转角底数。对应的,在 Transformer 每一层的 Attention 计算中, 位置的 向量和 位置的 的内积表示为:

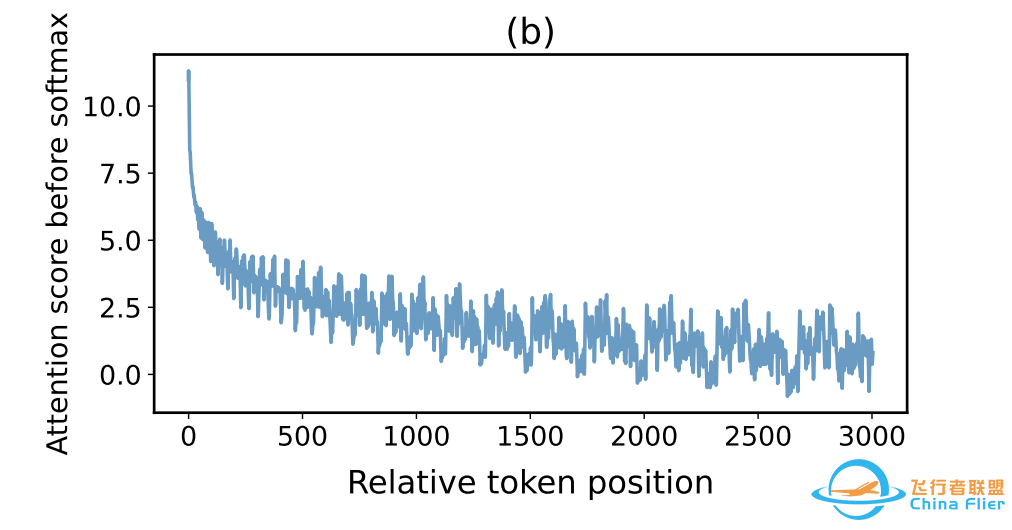

其中 和 表示向量的语义表示,为了关注位置对注意力分配的影响,作者将 q 和 k 设为全 1 向量以去除语义的干扰,最终计算得到的注意力上界如图 1 所示。可观察到当相对距离 增加时,模型的注意力在远程衰减的同时伴随着一种周期不规律的波形,该波形受 RoPE 底数 影响。

▲ 图1

许多工作研究过 RoPE 底数的性质,如增大底数并在长序列上微调 [2],可以帮助模型外推;或通过设定一个较大的底数进行 continue training [3],增强了模型的长文本生成能力。

而本文的作者则关注到 RoPE 底数可以控制模型注意力上界的波形,提出了一个猜想:位于注意力波形波谷的信息可能会受到较少的关注。如果这些信息对当前的预测很重要,可能会限制模型的准确生成能力。对此猜想,作者设计了一个实验来进行验证。

猜想验证:注意力波形影响上文感知

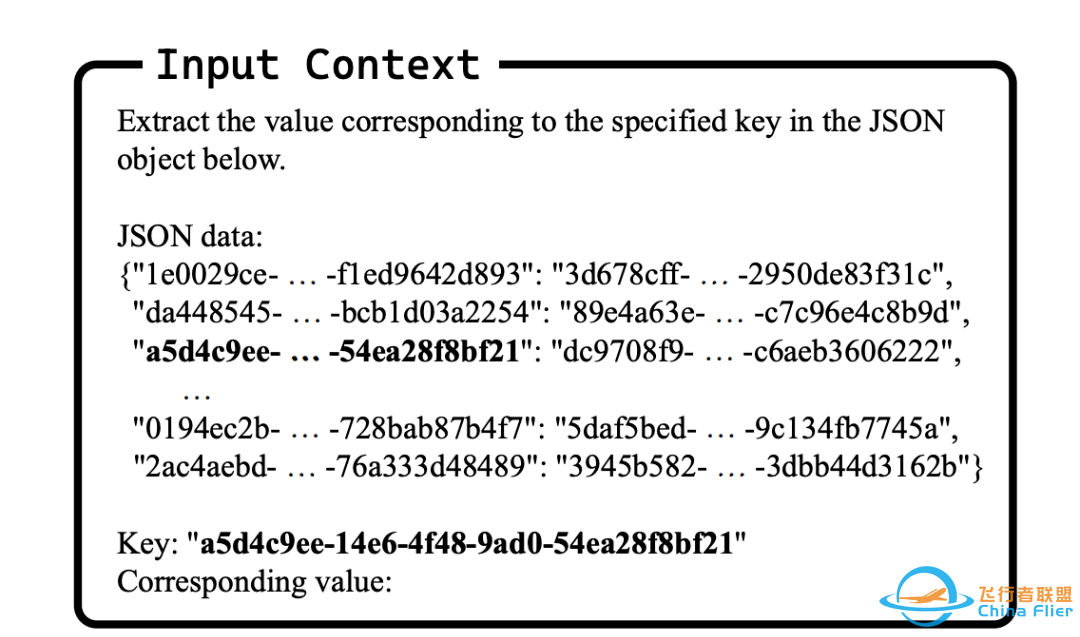

参考 Liu 等人 [4] 的实验设定,作者向模型输入 K 个键值对,所有的键值都是字符串格式。当指定一个目标键,模型需要从上下文中找到对应的值并生成。一个输入的示例如下图所示:

▲ 图2

为了探究将目标键值分别置于注意力波峰和波谷位置时,模型上下文感知能力的差异,作者通过调整目标键值在上文中的位置,并在多组 RoPE 底数,即多组注意力波形上做了实验。同时,作者还通过调整上文文档数 K,考察了不同上文长度的效应。

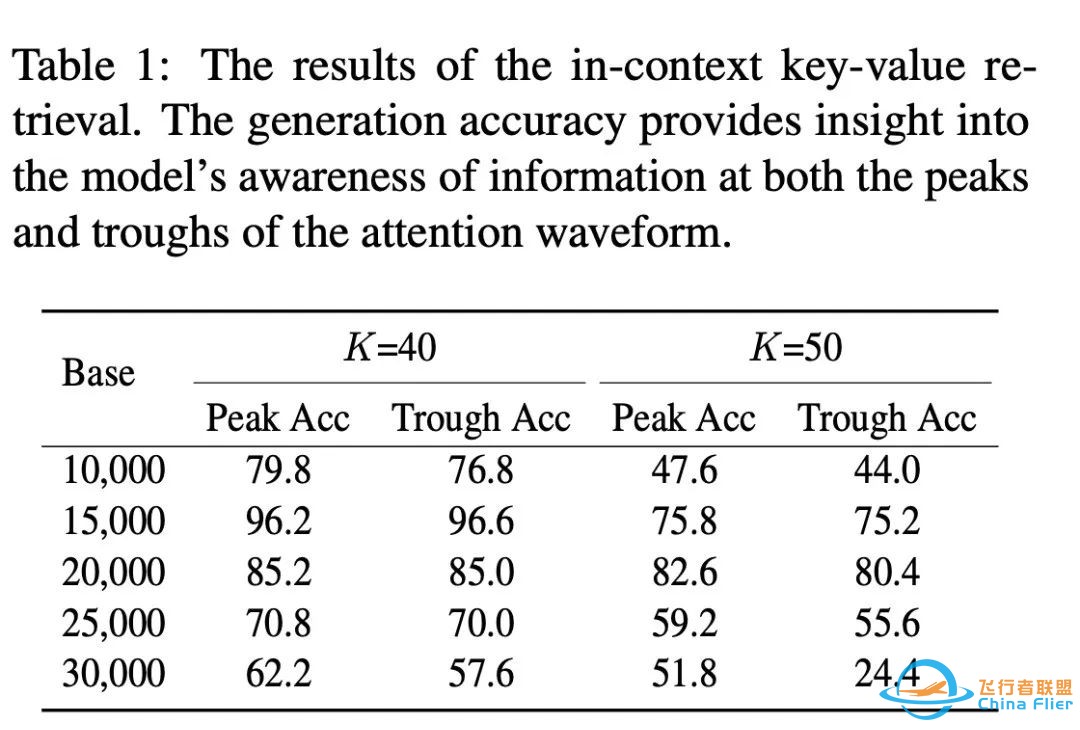

实验结果表明,将键值对置于注意力波峰位置确实比放在波谷位置,对于准确地生成期望的值更为有效。这一现象在不同的上下文长度和 RoPE 底数条件下都都成立。此外,作者发现,最佳的 RoPE 底数与上下文长度有关。例如,当上文文档数 K 设为 40 时,15,000 的底数表现最佳;而当 K 为 50 时,最佳底数则为 20,000。

▲ 表1

这些发现引出了以下见解与挑战:

见解:增强对注意力波形波谷位置信息的关注,可能会提升大型语言模型对上下文的敏感度,并进一步提高其整体性能。

挑战:在实际应用中,确定关键信息的准确位置通常非常困难,这使得选择合适的 RoPE 底数以确保对关键信息的有效关注成为一个重要挑战。

通过交织注意力波形增强上文感知

基于上述见解,作者提出了一种非常简单的方法来越过"需要对关键信息准确定位"的挑战:无需知道关键信息在什么位置,只需对同一个上文采用多个“互补”的注意力波形,则可保证即使关键信息在一个注意力波形中被忽视,也可以被另一个注意力波形所弥补。

具体来说,作者通过修改 RoPE 底数来控制注意力波形,并将最终结果进行加权融合来得到最后的输出。如下图所示,该方法主要包括以下步骤:给定一个上文 C,为了基于 C 生成响应 R,作者选择了 N 个不同的 RoPE 底数,即使用 N 个不同的注意力模式并行处理 C。最后将对应的输出加权求和,来获取最终的预测概率,并进行解码。

▲ 图4

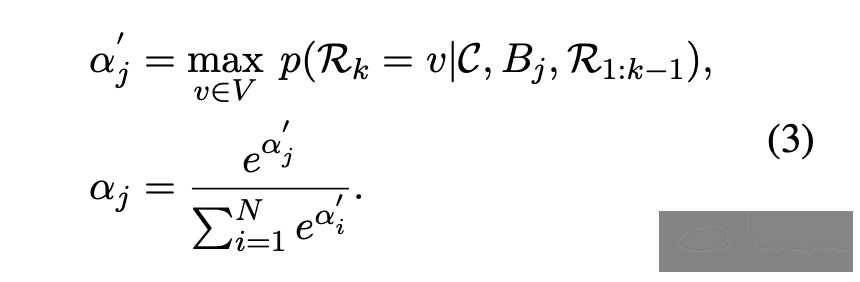

对于每个并行实例,其最终的加权权重基于一个假设:如果所采用的注意力模式成功捕捉到了关键信息,那么模型在生成当前 token 时会表现出高度的自信。因此,自信度更大的并行实例应被赋予更大的权重。作者采用以下方法量化预测的“自信度”:其中 V 代表模型词汇表,Bj 为选定的 RoPE 底数,Rk 代表当前生成响应中的第 k 个 token。

为了选出 个“互补”的注意力波形,这些波形集合被定义为集合 ,作者设计了以下算法。首先,作者定义了一个离散的底数搜索空间,表示为 ,其中 。这里的 和 分别代表最小和最大底数值, 是搜索步长。在搜索开始时,作者将 初始化为 , 为训练时采用的 RoPE 底数。在接下来的 N-1 次迭代中,作者每轮都从 中的候选底数中搜索出一个最优底数。这个最优底数的选择基于其波峰(波谷)位置与 中已有底数的注意力波形的低谷(波峰)位置的接近程度。为了方便理解,在下图中,作者展示了一个简化的选择过程。首先,作者识别出两个候选底数中的注意力波形的波峰(P)和波谷(T)的位置。接着,作者计算这些波峰和波谷与 集合中(此处假设只包含一个元素)相应底数的注意力波谷和波峰之间的距离。在本示例中,基于这种比较,候选 1 被选为最佳匹配。

▲ 图5为了帮助读者理解所提出的整个方法,作者采用了一个类比:当一个木桶有一些木板较短时,水会从短板处漏出,同样地,单一注意力波形上对上下文中特定位置的感知是有限的。当使用不同的注意力波形来处理上下文时,一个注意力波形的低谷会被另一个波的高峰加强,就像一个桶中较长的木板补偿了另一个桶中较短的木板一样。也正因此,作者将提出的方法命名为“Attention Buckets”。

实验

最近的研究将大型语言模型与工具结合起来,已经在多个领域取得了进步,例如人机交互、自动化多模态任务以及提高语言相关应用的整体效率。

在这一范式中,大型语言模型在接收到用户意图后,会访问多个工具文档,并选择最合适的一个工具。基于工具执行结果,模型提供准确适当的回应。鉴于大模型在工具使用的过程中,上文有如此多样且复杂的信息,工具使用任务要求 LLMs 有极高的感知和理解能力。因此,作者采用该任务,来验证其方法的有效性。

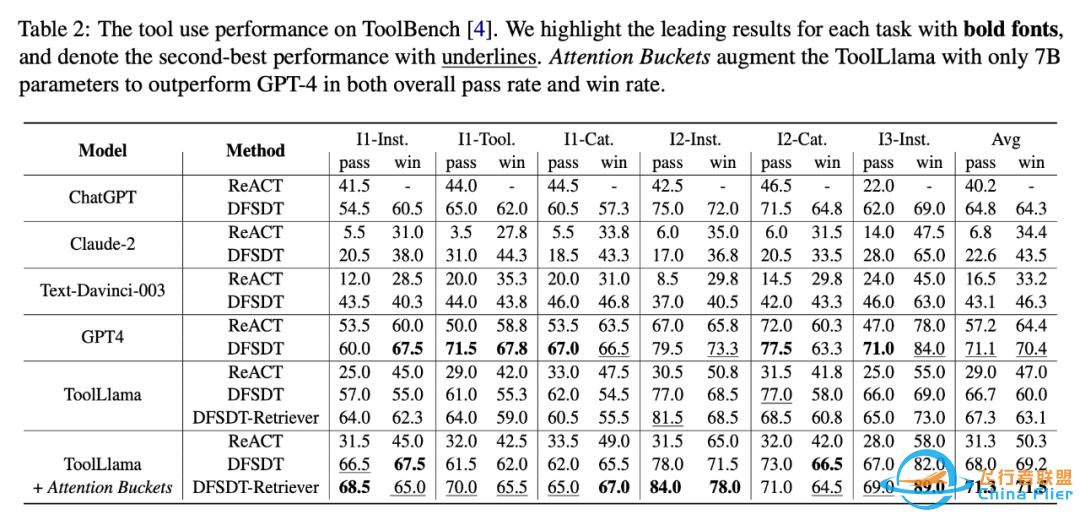

作者选择了 Toolbench [5],这是截至目前为止是用于评估大型语言模型工具使用能力的最大基准测试。Toolbench 的测试任务分为 6 个不同的难度,测试了模型对 in-domain 和 out-of-domain 工具使用和用户意图处理的能力。作者将提出的方法作用于 Toolbench 上训练的 7B 开源模型 ToolLlama,并使用了多种推理算法(ReAct,DFSDT 等)。 作者的实验结果如下所示:

▲ 表2

作者的方法在几乎所有任务级别和场景中都增强了 ToolLlama 的得分。值得注意的是,当与 DFSDT-Retriever 设置(在表格的最后一行)结合使用时,作者的方法不仅与 GPT-4 的性能水平相匹配,而且多数超越。平均而言,作者的方法以 71.3% 的最高测试通过率和 71.5% 相对 ChatGPT-ReACT 的质量胜率取得了超过 GPT4 的表现。

对于不同的推理方法,作者都在各自的基线上显示出显著的改进,展示了作者方法的多功能性和兼容性。这些结果共同表明,作者提出的“Attention Buckets”算法提高了 ToolLlama 的工具使用能力,这一成功作者归因于其增强的上下文意识。

这些结果使作者认为,语言模型拥有许多未被挖掘的潜力。通过有效利用这些能力,LLMs 可能比人们想象的要强大得多。希望本文的发现能激发进一步研究 LLMs 更基本能力的研究。

参考文献

[1] Su J, Ahmed M, Lu Y, et al. Roformer: Enhanced transformer with rotary position embedding[J]. Neurocomputing, 2023: 127063.

[2] Chen S, Wong S, Chen L, et al. Extending context window of large language models via positional interpolation[J]. arXiv preprint arXiv:2306.15595, 2023.

[3] Xiong W, Liu J, Molybog I, et al. Effective long-context scaling of foundation models[J]. arXiv preprint arXiv:2309.16039, 2023.

[4] Liu N F, Lin K, Hewitt J, et al. Lost in the middle: How language models use long contexts[J]. arXiv preprint arXiv:2307.03172, 2023.

[5] Qin Y, Liang S, Ye Y, et al. Toolllm: Facilitating large language models to master 16000+ real-world apis[J]. arXiv preprint arXiv:2307.16789, 2023.

欢迎加入我们

如果对我们的工作感兴趣的话,欢迎加入我们!

团队介绍:阿里通义实验室,主要负责通义系列大模型研究与产品落地。其中对话智能团队,以大模型研究和应用为中心,以对话为核心交互形态,推进大模型的大规模商业化应用,主要技术包括:1)对话大模型;2)代码大模型;3)AI Agents;4)对话、问答、Code、摘要、plugin、planning、人类对齐、高效训练等。

过去三年发表60+篇国际顶会论文, ACL 2023中稿9篇,NeurIPS 2023中稿2篇,EMNLP 2023中稿7篇;主要业务场景包括1)通义晓蜜—阿里云智能客服;2)通义百炼-企业专属大模型;3)通义灵码;4)通义听悟;5)钉钉斜杠。其中,阿里云智能客服在国内对话式AI市占率第一。

团队Google scholar:

https://scholar.google.com/citations?user=5QkHNpkAAAAJ

团队Github:

https://github.com/AlibabaResearch/DAMO-ConvAI

招聘岗位:大语言模型算法专家(P6/P7)/ Research Intern

工作地点:北京 & 杭州

岗位职责:

1. 负责代码大模型的训练和研究,包括但不限于Code Pretraining、SFT、Alignment等,并基于代码大模型打造具备代码生成、代码问答、单元测试、Code Review等功能的软件工程全链路智能化产品应用;

2. 负责对话大模型的训练与研究,打造multi-turn、grounding、planning、plugin等核心能力,并基于对话大模型构建新一代服务各行各业的AI Agents;

3. 负责构建企业专属大模型的相关技术研究和应用,包括但不限于prompt优化、数据合成、高效训练和自动评测等技术,并基于上述技术快速打造企业专属Agent的产品化落地;

4. 将上述技术在通义灵码、通义晓蜜、通义听悟、阿里云百炼等大模型产品进行大规模应用落地,并探索新的大模型应用产品形态。

岗位要求:

1. 在人工智能相关方向的硕士/博士,社招需要有扎实基础和丰富经验,Research Intern有NeurIPS/ICLR/ACL/EMNLP等顶会论文者优先;

2. 热爱技术,乐于用创新技术解决业务问题,有大模型经验者优先;

3. 具备优秀的分析问题和解决问题的能力,以及良好的沟通协作能力;

4. 具备技术洞察力、业务敏感度和数据分析能力,能应对复杂业务的算法需求。

简历投递:ting-en.lte@alibaba-inc.com

邮件标题和简历标明:姓名-岗位名称-PaperWeekly

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

|

|