本文介绍了 HazyDet,一个在恶劣天气条件下用于无人机目标检测的开源基准数据集,并提出了一种新的深度线索调制检测器(DeCoDet),利用深度信息提升检测性能。

论文标题:

HazyDet: Open-source Benchmark for Drone-view Object Detection with Depth-cues in Hazy Scenes

论文链接:

https://arxiv.org/abs/2409.19833

代码链接:

https://github.com/GrokCV/HazyDet

一、研究背景

在现代社会,无人机已经成为我们生活中不可或缺的一部分。它们被广泛应用于物流配送、农业监测、安防巡逻等多个领域。然而,当无人机在恶劣天气条件下执行任务时,面临的挑战也随之增加。

图1. 恶劣天气下工作的无人机

恶劣天气,如浓雾、大雨、暴风雪等,不仅会影响无人机的飞行稳定性,还会对其所搭载的传感器造成严重干扰。在这样的环境中,无人机需要更加可靠的感知能力,以确保任务的顺利完成和飞行的安全性。研究和开发能够在恶劣天气下有效工作的无人机目标检测技术,不仅能提高无人机的工作效率,还能拓展其在极端环境中的应用范围,确保在各种天气条件下都能可靠地执行任务。

二、相关数据集的匮乏

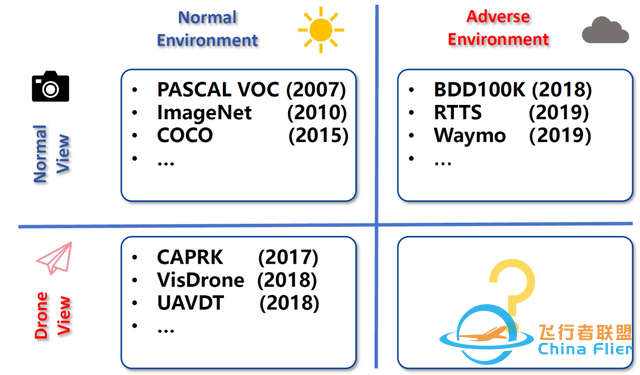

图2. 相关数据集

在计算机视觉领域,COCO 和 VOC 等数据集扮演了至关重要的角色,为目标检测和图像分割等任务提供了丰富的标注数据。近年来,针对无人机视角下,研究者们也开发了多个数据集。例如,CARPK数据集包括 1,448 张无人机拍摄的停车场图像,标注了 89,777 辆汽车。UAVDT 数据集提供了约 40,000 张图像,每张图像的分辨率约为 1080×540 像素,标注了城市环境中的汽车、公交车和卡车。VisDrone是最广泛使用的数据集之一,包含 10,209 张图像,详细标注了十个物体类别,包括边界框、遮挡和截断比例。这些数据集的出现极大地推动了深度学习算法的发展,使得研究人员能够在标准化的环境中测试和比较不同的方法。

然而,这些数据集通常集中在清晰、理想的正常天气条件下。随着无人机在恶劣环境中的部署日益增多,对于相关场景的数据需求更加明显。针对大雨、浓雾、暴风雪等极端天气的无人机目标检测数据集相对缺乏,成为了一个亟待解决的研究方向。

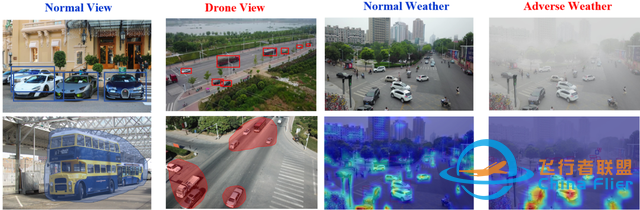

图3. 恶劣天气下的无人机目标检测所面临的挑战

三、现有方法

尽管通用目标检测领域取得了重要进展,但将这些方法直接应用于恶劣天气下的无人机目标检测往往未能达到预期效果,这主要是由于无人机视角和环境条件所致:

- 尺度变化:无人机图像由于视角和高度的变化,通常表现出显著的尺度变化,同时小物体的比例更高。

- 非均匀分布:与常规视角下目标集中于画面中心不同,无人机拍摄的图像中物体分布更为分散。

- 图像退化:在恶劣天气条件下,大气传输受损,导致能见度降低和图像颜色失真,影响图像质量,进而影响基于视觉的感知。

- 域间差距:天气引起的图像退化会影响特征识别,导致特征语义模糊,形成显著的域间差距。

为应对这些挑战,研究人员提出了一些针对性的设计:

- 多尺度特征融合[1][2][3]:通过特征金字塔和多分辨率架构捕捉不同尺度的物体,改善检测精度,缓解尺度变化的影响。

- 粗到细策略[4][5][6][7]:采用粗略检测器识别较大实例,再应用细粒度检测器定位较小目标,提高检测精度和效率。

- 图像恢复与检测结合[8][9][10]:将图像恢复与检测任务结合,学习从清晰和退化图像中提取域不变特征,增强对恶劣天气场景的理解。

尽管这些方法在某些方面取得了一定进展,但往往忽视了关键的辅助信息,例如场景深度。深度信息能够揭示物体与探测器之间的空间关系,从而帮助我们更好地理解场景中物体的布局和相对位置。此外,现有的检测流程通常表现出较为僵化和繁琐的设计,具体体现在多个方面:首先,许多检测流程需要进行多次前处理和后处理以及特种融合步骤,使得整个流程显得笨重且耗时;其次,结合图像恢复网络的方法往往受退化域数据的限制。此外,由于这检测和复原两种任务的优化目标存在差异,图像复原对检测任务的具体增益也存在不确定性。

四、HazyDet 数据集

图4. HazyDet 中的样本示例

为了解决数据集的空白,我们推出了HazyDet 数据集,重点关注雾这种普遍且会严重影响无人机感知的天气状况。HazyDet包含了上万张精心挑选的无人机图像,并为大约 383,000 个不同类别的物体标注了高质量的边界框。据我们所知,这是第一个专门为不利天气场景下的无人机检测设计的大规模数据集。

图5. HazyDet 构建流程

HazyDet 包含真实和仿真两种类型的数据。对于真实数据,我们采集了大量的真实雾霾场景下的无人机图像并进行了标注。然而,获取大量恶劣天气下包含目标的无人机图像十分困难,而且标注这些质量较低的图像需要耗费大量的人力和时间成本。因此,我们尝试利用现有已标注数据构建仿真数据。通过大气散射模型(Atmospheric Scattering Model,ASM)和精心设计的仿真参数,我们生成了高质量的仿真数据。

五、DeCoDet

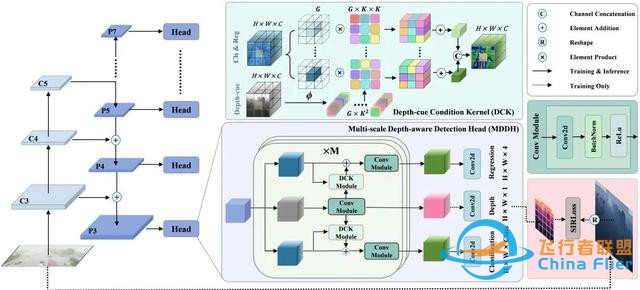

我们提出了一种新的检测框架——深度调制检测器(DeCoDet),如图6所示。DeCoDet 通过利用深度信息,而非显式的图像恢复,来增强雾霾条件下的检测性能。该框架建立在两个观察之上:一是无人机图像中物体特征与深度之间的相关性,二是场景中雾分布与深度的关系。

由于视角和高度的变化,无人机平台下的成像透视效应更加明显,远处物体的视觉尺寸显得更小,而近处物体则显得更大。此现象在常规视角和遥感视角中通常不明显。以往研究主要集中于利用深度数据检测伪装和显著目标,因为深度模态中的物体难以用颜色伪装[11][12][13]。然而,现有研究尚未充分利用深度信息与目标检测的更多联系,例如深度与场景中目标尺度的关系及不同深度下的目标分布。我们认为这些知识对于检测是有益的。

另一方面,在仿真过程中我们发现,雾天图像中的传输图(transmission map)与像素深度之间存在简单的负指数函数关系,也就是说,距离较远区域的传输图衰减程度更强。以往的去雾研究中,很多工作已经注意到深度信息的作用并将其引入到网络中[14][15],但我们认为深度信息的价值不仅限于低级视觉任务中的图像复原,它同样有助于网络在雾霾环境中进行更高阶的视觉感知,例如目标检测。

图6. DeCoDet 网络结构

基于上述发现,我们在现有网络中融合深度信息,并利用学习到的深度线索动态调整检测行为,最终得到深度调制检测器(Depth-cue Conditional Detector,DeCoDet),以有效应对雾霾环境和无人机视角带来的挑战,从而显著提高检测性能。六、实验

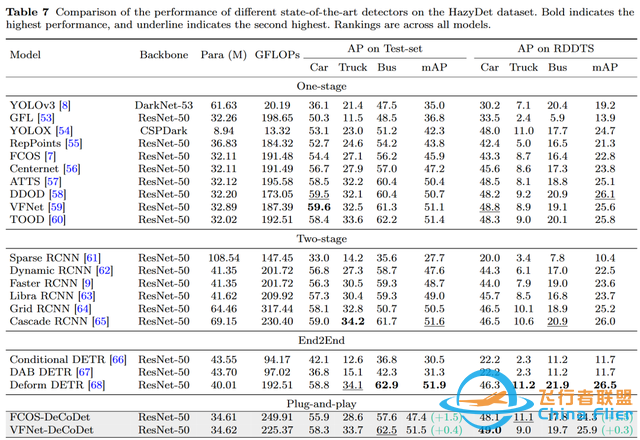

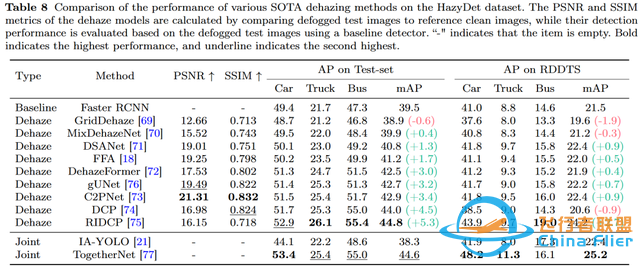

我们建立了一个全面的基准,以评估当前主流算法和 DeCoDet 在 HazyDet 数据集上的表现。首先,我们评估检测算法的性能;随后,我们评估最先进的去雾模型对检测效果的影响,相关结果如表1、表2所示。

表1. HazyDet 数据集上不同检测器的性能表现

表2. HazyDet 上不同去雾模型的表现

七、结论和未来工作的讨论

传统上,处理恶劣天气感知的策略主要有两类。第一类策略利用真实的恶劣天气数据来训练模型以增强其对未知域的适应能力。虽然这种方法较为根本,但由于恶劣天气数据的获取和标注成本较高,其应用受到很大限制。第二类策略则是通过域适应设计来缩小正常天气域与恶劣天气域之间的差异,然而这也仅能在某种程度上缓解问题。

最近,越来越多的工作注意到了在恶劣天气下深度信息的重要性,这些任务包括但不限于图像复原、光流估计以及实例分割,促使我们思考为什么深度信息对于恶劣天气下的感知如此重要。在我们看来,深度信息在恶劣天气下的感知中之所以重要,关键在于它能够提供一种相对稳定的感知基础。

恶劣天气(包括雨雪雾暗光等)的和正常天气的不同场景下,图像中的颜色纹理亮度等与光学成像相关的信息产生了巨大的偏差,这也是导致正产域与退化域差异的原因,但是对于深度信息来说却是不变的。同时,不同恶劣天气对于成像的影响与深度是十分相关的。例如,距离相机较近的对象主要受雨水条纹的影响,更多的光线反射到相机中,而距离较远的对象受雾和弱光条件的影响更大。对于一个模型来说,掌握了深度信息其实是一定程度的以不变应万变,以不变的深度特征来应对多变的但是与深度相关的恶劣天气。

目前,DeCoDet 只是对深度信息在目标检测中应用的粗浅尝试,仍然存在许多局限性,包括缺乏真实深度数据的应用、对基于深度的信息处理网络结构与方法的探索不足,以及未充分将深度信息应用于更广泛任务中(如雨、雪、暗光条件下的分割、场景定位、导航等)。未来工作我们将聚焦于这些方面,也非常欢迎更多同行可以共同探索。

致谢

我们感谢天津视觉计算与智能感知重点实验室(VCIP)提供的宝贵资源。特别感谢天津大学的朱鹏飞教授和 AISKYEYE 团队,他们对数据方面的重要支持对我们的研究工作至关重要。同时,我们对李翔辉、冯钰新及其他研究人员表示深切的感谢,他们在数据仿真和数据集构建方面提出了宝贵的意见。此外,我们也要感谢Metric3D 对本文所呈现方法的贡献。参考文献

[1]: Qi Zhao, Binghao Liu, Shuchang Lyu, Chunlei Wang, and Hong Zhang. TPH-YOLOv5++: Boosting Object Detection on Drone-Captured Scenarios with Cross-Layer Asymmetric Transformer. Remote Sensing, 15(6):1687, March 2023.[2]: Guanqiu Qi, Yuanchuan Zhang, Kunpeng Wang, Neal Mazur, Yang Liu, and Devanshi Malaviya. Small Object Detection Method Based on Adaptive Spatial Parallel Convolution and Fast Multi-Scale Fusion. Remote Sensing, 14(2):420, January 2022.[3]: Yunzuo Zhang, Cunyu Wu, Tian Zhang, Yameng Liu, and Yuxin Zheng. Self-Attention Guidance and Multiscale Feature Fusion-Based UAV Image Object Detection. IEEE Geoscience and Remote Sensing Letters, 20:1–5, 2023.[4]: Fan Yang, Heng Fan, Peng Chu, Erik Blasch, and Haibin Ling. Clustered Object Detection in Aerial Images. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 8311–8320, 2019.[5]: Sutao Deng, Shuai Li, Ke Xie, Wenfeng Song, Xiao Liao, Aimin Hao, and Hong Qin. A Global-Local Self-Adaptive Network for Drone-View Object Detection. IEEE Transactions on Image Processing, 30:1556–1569, 2021.[6]: Jingtao Xu, Ya-Li Li, and Shengjin Wang. AdaZoom: Towards Scale-Aware Large Scene Object Detection. IEEE Transactions on Multimedia, 25:4598–4609, 2023.[7]: Yecheng Huang, Jiaxin Chen, and Di Huang. UFPMP-Det: Toward Accurate and Efficient Object Detection on Drone Imagery. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 36, pages 1026–1033, 2022.[8]: Shih-Chia Huang, Trung-Hieu Le, and Da-Wei Jaw. DSNet: Joint Semantic Learning for Object Detection in Inclement Weather Conditions. IEEE Transactions on Pattern Analysis and Machine Intelligence, 42(6):1406–1420, 2020.[9]: Wenyu Liu, Gaofeng Ren, Runsheng Yu, Shi Guo, Jianke Zhu, and Lei Zhang. Image-Adaptive YOLO for Object Detection in Adverse Weather Conditions. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 36, pages 1792–1800, 2022.[10]: Chengyang Li, Heng Zhou, Yang Liu, Caidong Yang, Yongqiang Xie, Zhongbo Li, and Liping Zhu. Detection-Friendly Dehazing: Object Detection in Real-World Hazy Scenes. IEEE Transactions on Pattern Analysis and Machine Intelligence, 45(7):1–12, 2023.[11]: Long Li, Junwei Han, Nian Liu, Salman Khan, Hisham Cholakkal, Rao Muhammad Anwer, and Fahad Shahbaz Khan. Robust Perception and Precise Segmentation for Scribble-Supervised RGB-D Saliency Detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023.[12]: Congyan Lang, Tam V. Nguyen, Harish Katti, Karthik Yadati, Mohan Kankanhalli, and Shuicheng Yan. Depth Matters: Influence of Depth Cues on Visual Saliency. In European Conference on Computer Vision (ECCV), pages 101–115. Springer, 2012.[13]: Yunqiu Lv, Jing Zhang, Yuchao Dai, Aixuan Li, Nick Barnes, and Deng-Ping Fan. Towards Deeper Understanding of Camouflaged Object Detection. IEEE Transactions on Circuits and Systems for Video Technology, 2023.[14]: Yang Yang, Chun-Le Guo, and Xiaojie Guo. Depth-Aware Unpaired Video Dehazing. IEEE Transactions on Image Processing, 33:2388–2403, 2024.[15]: Y. Zhang, S. Zhou, and H. Li. Depth Information Assisted Collaborative Mutual Promotion Network for Single Image Dehazing. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pages 2846–2855, 2024. doi: 10.1109/CVPR52733.2024.00275.

llustration From IconScout By IconScout Store

-The End-

扫码观看!

本周上新!

“AI技术流”原创投稿计划

TechBeat是由将门创投建立的AI学习社区(www.techbeat.net)。社区上线500+期talk视频,3000+篇技术干货文章,方向覆盖CV/NLP/ML/Robotis等;每月定期举办顶会及其他线上交流活动,不定期举办技术人线下聚会交流活动。我们正在努力成为AI人才喜爱的高质量、知识型交流平台,希望为AI人才打造更专业的服务和体验,加速并陪伴其成长。

投稿内容

// 最新技术解读/系统性知识分享 //

// 前沿资讯解说/心得经历讲述 //

投稿须知

稿件需要为原创文章,并标明作者信息。

我们会选择部分在深度技术解析及科研心得方向,对用户启发更大的文章,做原创性内容奖励

投稿方式

发送邮件到

melodybai@thejiangmen.com

或添加工作人员微信(yellowsubbj)投稿,沟通投稿详情;还可以关注“将门创投”公众号,后台回复“投稿”二字,获得投稿说明。

关于我“门”▼

将门是一家以专注于数智核心科技领域的新型创投机构,也是北京市标杆型孵化器。公司致力于通过连接技术与商业,发掘和培育具有全球影响力的科技创新企业,推动企业创新发展与产业升级。

将门成立于2015年底,创始团队由微软创投在中国的创始团队原班人马构建而成,曾为微软优选和深度孵化了126家创新的技术型创业公司。

如果您是技术领域的初创企业,不仅想获得投资,还希望获得一系列持续性、有价值的投后服务,欢迎发送或者推荐项目给我“门”:

[img=189px,106]https://p3-sign.toutiaoimg.com/tos-cn-i-tjoges91tu/9c553749379e46e7ed8693d1adf9d557~tplv-tt-large.image?_iz=30575&lk3s=06827d14&x-expires=1732077935&x-signature=I7xfhs09Cex0lQNROrh5P0qBIJY%3D[/img] |