来源:计算机视觉工坊

添加小助理:cv3d008,备注:方向+学校/公司+昵称,拉你入群。文末附3D视觉行业细分群。

加入「3D视觉从入门到精通」知识星球,星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门秘制视频课程、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎加入!

0. 论文信息

标题:STCMOT: Spatio-Temporal Cohesion Learning for UAV-Based Multiple Object Tracking

作者:Jianbo Ma, Chuanming Tang, Fei Wu, Can Zhao, Jianlin Zhang, Zhiyong Xu

原文链接:https://arxiv.org/abs/2409.11234

代码链接:https://github.com/ydhcg-BoBo/STCMOT

1. 引言

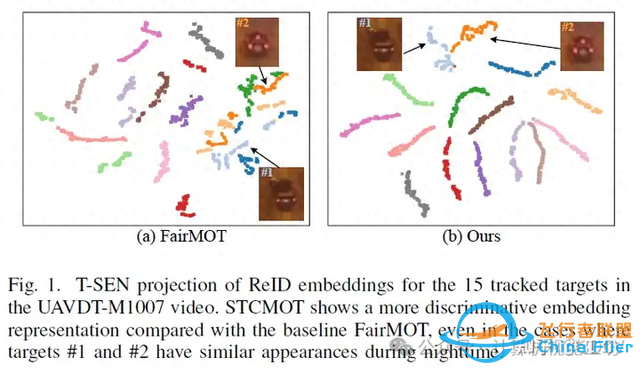

多目标跟踪(MOT)的目标是在视频序列中识别出各种指定的目标类别。近年来,针对无人机(UAV)视频的多目标跟踪算法引起了研究人员的兴趣。其主要任务在于有效地跟踪无人机视角下的多个目标。然而,由于目标与无人机摄像机之间的距离,目标通常较小且易于模糊,这给基于无人机的多目标跟踪任务带来了许多挑战性特征。与固定拍摄不同,无人机的动态运动导致地面目标位置持续变化以及相关的多维缩放问题。因此,无人机跟踪的性能很容易受到相似干扰物和遮挡的干扰。

为应对这些挑战,以往的工作主要利用两阶段跟踪框架来增强跟踪能力。它们首先引入检测模型来确定目标的位置,然后建立目标候选物的运动信息和再识别(ReID)嵌入,并将其连接起来以完成匹配。尽管这些两阶段跟踪器表现出色,但分别使用网络进行目标检测和嵌入提取会导致大量的存储成本和资源消耗。为此,单次跟踪算法将检测分支和ReID分支集成到一个统一的框架中,以平衡跟踪性能和速度。例如,FairMOT将额外的ReID分支合并到CenterNet中,它以单帧图像为输入,同时生成检测到的目标和相应的嵌入特征。这种简化的跟踪框架可以简化跟踪过程,因此更适合于无人机视频中的现实世界目标跟踪。

此外,随着深度卷积网络的进步,一些工作在单次跟踪框架中使用增强的深度特征,并取得了更高的性能。为了获得多特征层次的像素级关系,Wu等人首先为检测分支设计了一个金字塔Transformer编码器,然后使用配备金字塔融合网络的通道级Transformer编码器来增强ReID分支。同时,Yu等人提出了一个引导Transformer编码器来强调全局语义信息。Liang等人引入了一个尺度感知注意力网络来缓解目标语义不对齐问题。除了从全局和局部空间角度增强特征表示外,Liu等人还对ID特征的时序关系进行建模,并提出了一个ID特征更新模块,以适应无人机视角下的各种外观变化。然而,这些工作尚未认真考虑来自检测分支的多个目标的时空线索,这启发了我们构建检测和ReID分支之间的时空交互模型来处理复杂的跟踪场景,如目标变形和模糊。

在本文中,我们提出了一种用于无人机捕获视频中的多目标跟踪的统一时空连贯学习网络,称为STCMOT。STCMOT将历史帧中的显著ReID嵌入扩展到当前帧,优化并增强了检测和ReID分支。具体来说,我们首先引入了一个时序嵌入增强模块,它将相邻帧的ReID特征图进行耦合,并生成一个通道级描述符,以突出单个嵌入的判别性。其次,基于视频序列中单个嵌入的固有连续性,构建了一个时序检测细化模块。该模块将每个先前的目标嵌入视为查询,以促进在单次网络训练过程中与当前ReID特征图的信息交互。

通过这种方式,目标的时空耦合策略可以同时优化检测和ReID分支,从而增强网络的关联能力并减少跟踪失败。实验结果表明,该方法在MOTA和IDF1指标上均超过了当前最先进的跟踪器。

2. 摘要

无人飞行器(UAV)视频中的多目标跟踪(MOT)对于计算机视觉中的各种应用非常重要。当前的MOT跟踪器依赖于精确的目标检测结果和目标再识别的精确匹配(ReID)。这些方法侧重于优化目标空间属性,而忽略了建模对象关系中的时间线索,特别是对于具有挑战性的跟踪条件,如对象变形和模糊等。为了解决上述问题,我们提出了一种新的时空内聚多目标跟踪框架(STCMOT ),该框架利用历史嵌入特征按顺序对ReID和检测特征的表示进行建模。具体而言,引入时间嵌入增强模块来增强基于相邻帧协作的个体嵌入的可区分性。而轨迹嵌入然后由时间检测细化模块传播,以挖掘时间场中的显著目标位置。在VisDrone2019和UAVDT数据集上进行的大量实验表明,我们的STCMOT在MOTA和IDF1指标上创造了新的一流性能。

3. 效果展示

4. 主要贡献

本文的主要贡献可以总结为以下三个方面:

• 我们强调了在MOT中引入连续帧ReID特征图的重要性。提出了一种时序嵌入增强模块(TEBM),以提高特征通道层面上单个嵌入的特异性。

• 我们提出了一种名为TDRM的时序检测细化模块。该模块旨在利用目标的运动连续性和轨迹嵌入来细化细粒度目标位置并增强检测性能。推荐课程:零基础入门四旋翼建模与控制(MATLAB仿真)[理论+实战]。

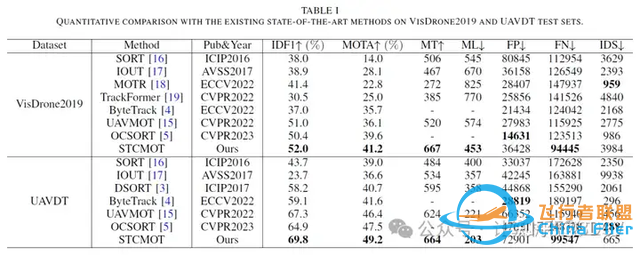

• 通过提出的时空语义嵌入连贯策略,STCMOT在VisDrone2019和UAVDT基准测试中均取得了新的最先进性能。

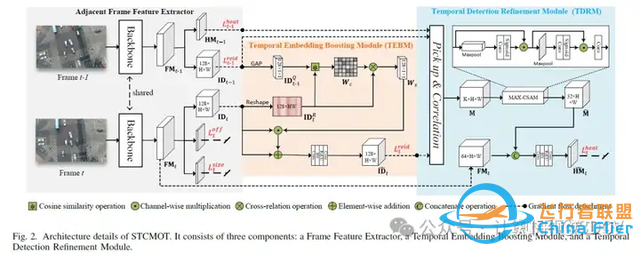

5. 方法

如图2所示,STCMOT可以分为三个部分:相邻帧特征提取器、时间嵌入增强模块(TEBM)和时间检测细化模块(TDRM)。整体流程可以描述如下:首先,无人机平台收集视频序列,并将两个相邻帧(例如,第t-1帧和第t帧)输入到特征提取器中。然后,我们的ReID模块将ReID嵌入增强为IˆDt ∈ R128×H×W,检测模块将检测热图细化为HˆMt ∈ RC×H×W。这里,C表示目标类别,H、W分别表示相应特征图的高度和宽度。具体来说,TEBM通过结合相邻帧的ReID特征图来增强单个嵌入的鲁棒性和显著性。基于跟踪轨迹在整个视频序列中嵌入的固有连续性,提出了TDRM来恢复和增强检测阶段中目标的位置。

特征提取器。如图2所示,我们的框架采用权重共享的主干网络(DLA-34)来获取前一帧FMt−1 ∈ R64×H×W和当前帧FMt ∈ R64×H×W的原始特征图。原始特征图FMt−1通过单独的3×3卷积层、ReLU层和1×1卷积层,得到检测热图HMt−1 ∈ RC×H×W和ReID特征图IDt−1 ∈ R128×H×W。同样,我们从FMt中获得初始结果,包括ReID特征图IDt ∈ R128×H×W、R2×H×W的框偏移量和R2×H×W的框大小。

6. 实验结果

7. 总结 & 未来工作

在本文中,我们提出了一种新颖的时空特征一致性框架,用于无人机基础上的多目标跟踪(MOT)任务,该框架同时考虑了重识别(ReID)和检测分支的序列时间一致性。对于ReID分支,我们引入了时间嵌入增强模块(TEBM),该模块评估相邻ReID特征图之间的相似性,以增强单个嵌入特征的独特性。对于检测分支,我们提出了时间检测细化模块(TDRM),用于传播轨迹嵌入并显著突出潜在目标位置。实验表明,我们提出的STCMOT(时空特征一致性多目标跟踪)可以有效减少漏检目标的发生,并提高跟踪一致性。此外,STCMOT在流行的无人机基础上的MOT基准测试中达到了新的最先进水平。特别是在VisDrone2019数据集上,STCMOT实现了52.0%的IDF1和41.2%的MOTA;在UAVDT数据集上,分别实现了69.3%的IDF1和48.9%的MOTA。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

3D视觉工坊提供35个顶会论文的辅导课题如下:

1、基于环境信息的定位,重建与场景理解

2、轻是级高保真Gaussian Splatting

3、基于大模型与GS的 6D pose estimation

4、在挑战性遮挡环境下的GS-SLAM系统研究

5、基于零知识先验的实时语义地图构建SLAM系统

6、基于3DGS的实时语义地图构建

7、基于文字特征的城市环境SLAM

8、面向挑战性环境的SLAM系统研究

9、特殊激光传感器融合视觉的稠密SLAM系统

10、基于鲁棒描述子与特征匹配的特征点法SLAM

11、基于yolo-world的语义SL系统

12、基于自监督分割的挑战性环境高斯SLAM系统

13、面向动态场景的视觉SLAM系统研究

14、面向动态场景的GS-SLAM系统研究

15、集成物体级地图的GS-SLAM系统

16、挑战场景下2D-2D,2D-3D或3D-3D配准问题

17、未知物体同时重建与位姿估计问题类别级或开放词汇位姿估计问题

18、位姿估计中的域差距问题

19、可形变对象(软体)的实时三维重建与非刚性配准

20、机器人操作可形变对象建模与仿真

21、基于图像或点云3D目标检测、语义分割、轨迹预测.

22、医疗图像分割任务的模型结构设计

23、多帧融合的单目深度估计系统研究

24、复杂天气条件下的单目深度估计系统研究高精度的单目深度估计系统研究

25、基于大模型的单目深度估计系统研究

26、高精度的光流估计系统多传感器融合的单目深度估计系统研究

27、基于扩散模型的跨域鲁棒自动驾驶场景理解

28、水下图像复原/增强

30、Real-World图像去雾(无监督/物理驱动)

31、LDR图像/视频转HDR图像/视频

32、光场图像增强/复原/超分辨率

33、压缩后图像/视频的增强/复原

34、图像色彩增强(image retouching)

3D视觉交流群,成立啦!

目前我们已经建立了3D视觉方向多个社群,包括 2D计算机视觉 、 最前沿 、 工业3D视觉 、 SLAM 、 自动驾驶 、 三维重建 、 无人机 等方向,细分群包括:

工业3D视觉 :相机标定、立体匹配、三维点云、结构光、机械臂抓取、缺陷检测、6D位姿估计、相位偏折术、Halcon、摄影测量、阵列相机、光度立体视觉等。

SLAM :视觉SLAM、激光SLAM、语义SLAM、滤波算法、多传感器融合、多传感器标定、动态SLAM、MOT SLAM、NeRF SLAM、机器人导航等。

自动驾驶:深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器、多传感器标定、多传感器融合、自动驾驶综合群等、3D目标检测、路径规划、轨迹预测、3D点云分割、模型部署、车道线检测、Occupancy、目标跟踪等。

三维重建 :3DGS、NeRF、多视图几何、OpenMVS、MVSNet、colmap、纹理贴图等

无人机 :四旋翼建模、无人机飞控等

2D计算机视觉 :图像分类/分割、目标/检测、医学影像、GAN、OCR、2D缺陷检测、遥感测绘、超分辨率、人脸检测、行为识别、模型量化剪枝、迁移学习、人体姿态估计等

最前沿 :具身智能、大模型、Mamba、扩散模型等

除了这些,还有求职、硬件选型、视觉产品落地、产品、行业新闻等交流群

添加小助理: cv3d008,备注: 研究方向+学校/公司+昵称 (如 3D点云+清华+小草莓 ), 拉你入群。

3D视觉工坊官网:www.3dcver.com

包括但不限于:具身智能、3DGS、NeRF 、 结构光、相位偏折术、机械臂抓取、点云实战、Open3D、缺陷检测 、 BEV感知、Occupancy、Transformer、模型部署、3D目标检测、深度估计、多传感器标定、规划与控制 、 无人机仿真 、 C++、三维视觉python、dToF、相机标定、ROS2 、 机器人控制规划、LeGo-LAOM、多模态融合SLAM、LOAM-SLAM、室内室外SLAM、VINS-Fusion、ORB-SLAM3、MVSNet三维重建、colmap 、线面结构光等系列教程。除此之外还包括结构光相机、手持扫描仪、高精度标定板和一对一论文辅导等。 |